傳統GPU驅動模型的能耗困境

當前主流大語言模型(LLM)如ChatGPT依賴GPU芯片進行訓練與推理,此類模型在處理海量數據時需要強大算力支撐,導致能耗問題日益凸顯。數據中心為支持聊天機器人等應用消耗大量電力,引發業界對可持續發展的擔憂。研究團隊針對這一痛點展開技術攻關,提出更智能的數據處理方法。

1位架構實現算力優化

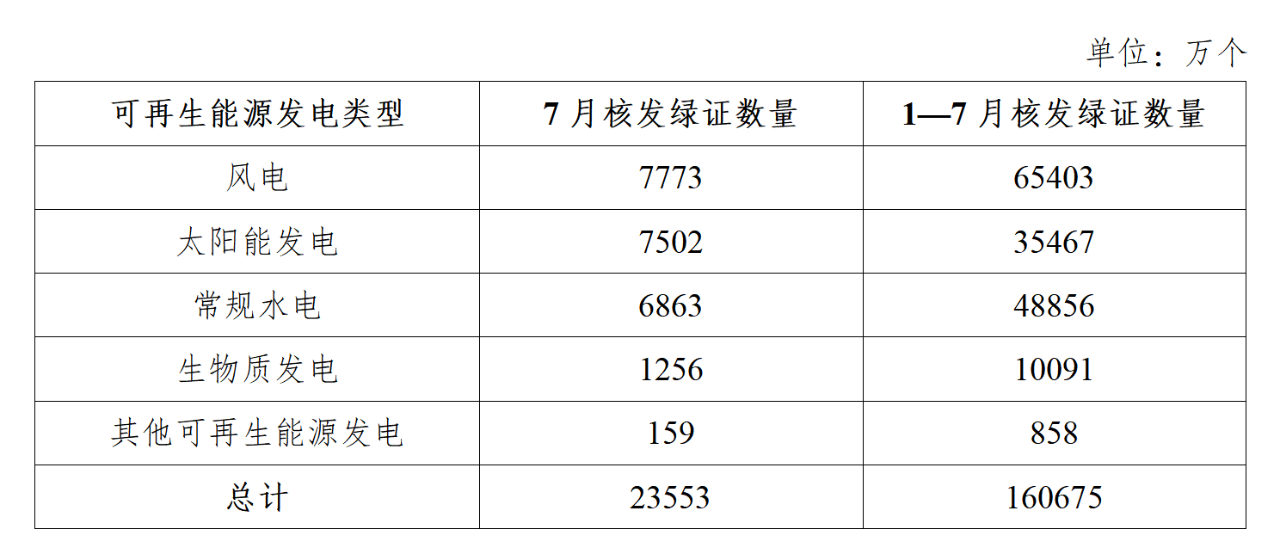

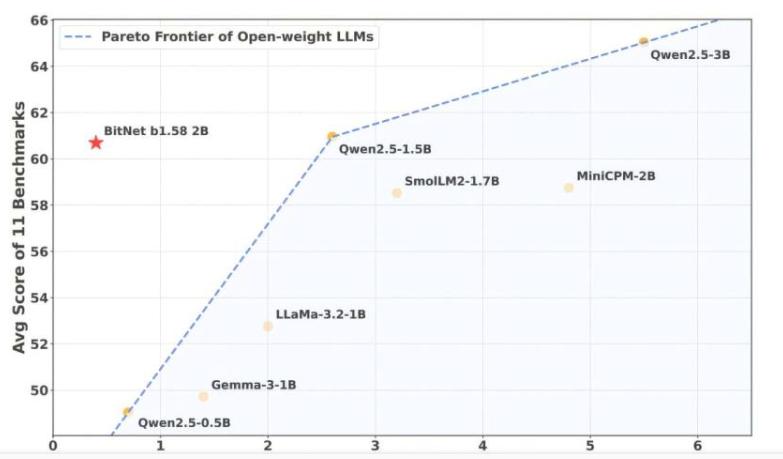

新模型摒棄傳統8位或16位浮點數存儲權重的方式,轉而采用“1位架構”。其核心創新在于將模型權重簡化為-1、0、1三種離散值,使推理過程僅需基礎加減法運算。這種設計極大降低了內存占用與CPU處理負擔,實驗數據顯示該架構在保持性能的同時,內存需求減少至傳統方案的1/16,能耗降低超90%。研究團隊強調,此方法使普通計算機或移動設備即可運行高效AI模型,無需依賴專業GPU硬件。

BitNet b1.58模型與專用運行環境

為適配1位架構,團隊開發了配套運行時環境bitnet.cpp。該系統針對離散權重矩陣優化內存分配與指令調度,支持20億參數規模的模型在單核CPU上穩定運行。測試結果表明,新模型在CPU環境下的推理速度接近傳統GPU方案,且模型精度損失控制在可接受范圍內。在MNIST、GLUE等基準測試中,其性能表現與同類GPU模型相當,部分場景下甚至實現超越。

本地化部署提升隱私與能效

該技術突破為AI應用帶來雙重價值。在隱私保護層面,用戶數據無需上傳云端即可完成處理,支持完全離線的智能助手開發。研究團隊在樹莓派等邊緣設備上成功部署聊天機器人系統,響應延遲低于300毫秒,且支持斷網運行。在能效層面,單個推理任務的耗電量較傳統方案減少92%,單次交互能耗不足0.03Wh。這一特性使其在移動終端、物聯網設備等場景中具備顯著優勢。